faint hadoop

失误删除了服务器上的hadoop,不得不重新配置。

格式化后,说啥也启动不起来。

没办法,放弃自己diy后的hadoop版本,然后下载了最新的hadoop。

还是启动不起来。

记录一下全新配置hadoop的问题:

(1)更改conf下的hadoop-env.sh

export JAVA_HOME=

(2)core-site.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 | <?xml version="1.0"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!-- Put site-specific property overrides in this file. --><configuration> <property> <name>fs.default.name</name> </property> <property> <name>hadoop.tmp.dir</name> <value>/workspace/xianmin/tmp</value> </property></configuration> |

(3)hdfs-site.xml

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 | <?xml version="1.0"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!-- Put site-specific property overrides in this file. --><configuration> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.data.dir</name> <value>/workspace/xianmin/data</value> </property> <property> <name>dfs.name.dir</name> <value>/workspace/xianmin/name</value> </property></configuration> |

(4)mapred-site.xml

1 2 3 4 5 6 7 8 9 10 11 | <?xml version="1.0"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!-- Put site-specific property overrides in this file. --><configuration> <property> <name>mapred.job.tracker</name> <value>cn50:9001</value> </property></configuration> |

注意这里一定要用cnxx,调试了两天的错误就是因为format的时候找不到host,fuck。

当然需要/etc/hosts要设定cnxx

(5)把hdfs-site.xml和mapred-site.xml复制到hdfs/conf和mapred/conf下

format 然后 启动

ubuntu 解压缩

.tar

解包:tar xvf FileName.tar

打包:tar cvf FileName.tar DirName

(注:tar是打包,不是压缩!)

---------------------------------------------

.gz

解压1:gunzip FileName.gz

解压2:gzip -d FileName.gz

压缩:gzip FileName

.tar.gz 和 .tgz

解压:tar zxvf FileName.tar.gz

压缩:tar zcvf FileName.tar.gz DirName

---------------------------------------------

.bz2

解压1:bzip2 -d FileName.bz2

解压2:bunzip2 FileName.bz2

压缩: bzip2 -z FileName

.tar.bz2

解压:tar jxvf FileName.tar.bz2

压缩:tar jcvf FileName.tar.bz2 DirName

---------------------------------------------

.bz

解压1:bzip2 -d FileName.bz

解压2:bunzip2 FileName.bz

压缩:未知

.tar.bz

解压:tar jxvf FileName.tar.bz

压缩:未知

---------------------------------------------

.Z

解压:uncompress FileName.Z

压缩:compress FileName

.tar.Z

解压:tar Zxvf FileName.tar.Z

压缩:tar Zcvf FileName.tar.Z DirName

---------------------------------------------

.zip

解压:unzip FileName.zip

压缩:zip FileName.zip DirName

---------------------------------------------

.rar

解压:rar x FileName.rar

压缩:rar a FileName.rar DirName

rar请到:http://www.rarsoft.com/download.htm 下载!

解压后请将rar_static拷贝到/usr/bin目录(其他由$PATH环境变量指定的目录也可以):

[root@www2 tmp]# cp rar_static /usr/bin/rar

---------------------------------------------

.lha

解压:lha -e FileName.lha

压缩:lha -a FileName.lha FileName

lha请到:http://www.infor.kanazawa-it.ac.jp/~ishii/lhaunix/下载!

>解压后请将lha拷贝到/usr/bin目录(其他由$PATH环境变量指定的目录也可以):

[root@www2 tmp]# cp lha /usr/bin/

---------------------------------------------

.rpm

解包:rpm2cpio FileName.rpm | cpio -div

---------------------------------------------

.deb

解包:ar p FileName.deb data.tar.gz | tar zxf -

---------------------------------------------

.tar .tgz .tar.gz .tar.Z .tar.bz .tar.bz2 .zip .cpio .rpm .deb .slp .arj .rar .ace .lha .lzh .lzx .lzs .arc .sda .sfx .lnx .zoo .cab .kar .cpt .pit .sit .sea

解压:sEx x FileName.*

压缩:sEx a FileName.* FileName

sEx只是调用相关程序,本身并无压缩、解压功能,请注意!

sEx请到: http://sourceforge.net/projects/sex下载!

解压后请将sEx拷贝到/usr/bin目录(其他由$PATH环境变量指定的目录也可以):

[root@www2 tmp]# cp sEx /usr/bin/

monet+xquery in ubuntu 10.04

Create a file /etc/apt/sources.list.d/monetdb.list with the following contents (replacing "karmic" as needed with "lenny", "lucid" or "maverick"):

deb http://dev.monetdb.org/downloads/deb/ karmic monetdb deb-src http://dev.monetdb.org/downloads/deb/ karmic monetdb

ubuntu 10.04: use "lucid" to replace "karmic"

wget --output-document=- http://dev.monetdb.org/downloads/MonetDB-GPG-KEY | apt-key add -

sudo apt-get update

sudo apt-get install monetdb-xquery monetdb-client

sudo usermod -a -G monetdb $USER

使用:

启动server:Mserver --dbinit="module(pathfinder);"

启动clinet:mclient -lx

hadoop safe mode

让Hadoop不处在safe mode 模式下,只要在Hadoop的目录下输入:

bin/hadoop dfsadmin -safemode leave

bibentry的用法

网上找到bibentry的用法,无外乎\usepackage, \nobibliography*, \nobibliography{}等用法。

但是把我的tex文件用上bibentry时总是有错误,原始文件如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 | \documentclass[11pt,twocolumn,a4paper]{article}\usepackage{CJK}\usepackage{xspace}\usepackage{bibentry}\usepackage{natbib}\usepackage[dvipdfm, %pdflatex,pdftex 这里决定运行文件的方式不同 pdfstartview=FitH, CJKbookmarks=true, bookmarksnumbered=true, bookmarksopen=true, colorlinks, %注释掉此项则交叉引用为彩色边框(将colorlinks和pdfborder同时注释掉) pdfborder=001, %注释掉此项则交叉引用为彩色边框 linkcolor=blue, anchorcolor=blue, citecolor=blue, pagebackref ]{hyperref}\usepackage{epsfig}\usepackage{amssymb}\usepackage{amsmath}\usepackage{amsfonts}\nobibliography*\begin{document}\begin{CJK*}{GBK}{kai}\author{}\title{LSH的下界}\maketitle\input{lsh}\begin{abstract}给定一个测度空间$(X,d_X)$,$c\geq{1}$,$r>0$,并且$p,q\in{[0,1]}$,一个从$X$到$\mathbb{N}$上的mapping的分布$\mapH$$:X\rightarrow{\mathbb{N}}$被称为一个$(r,cr,p,q)-sensitive$的hash函数族,如果(1)对于$X$中的两个距离至多是$r$的点,$\mapH$把他们映射为相同值的概率至少是$p$,(2)而对于距离大于$cr$的两个点,$\mapH$把他们映射为相同值的概率至多是$q$。这个概念在1996年被Indyk和Motwani引进作为一个高效的最近邻搜索的算法的基础。算法的性能被一个参数$\rho=\frac{\log(1/p)}{\log(1/q)}$控制,构造具有更小的$\rho$就会很自然地提供更好的nearest neighbor的算法。本文中,我们证明对于$X=l_1$,基本上想做到$\rho\leq{\frac{1}{2c}}$。这个结构几乎已经match了Indyk和Motwani给出的上界$\rho\leq{\frac{1}{c}}$。\end{abstract}\clearpage\end{CJK*}\bibliographystyle{plainnat}{\small\bibliography{BibDataQuality}}\end{document} |

编译:latex, bibtex, latex, latex

总是出错:

例如: latex error: Command \BR@bibitem already defined.

\par <insert text>

最后发现是hyperref的问题,改为下列就好了

1 2 3 4 5 6 7 8 9 10 11 12 | \usepackage[dvipdfm, %pdflatex,pdftex 这里决定运行文件的方式不同 pdfstartview=FitH, CJKbookmarks=true, bookmarksnumbered=true, bookmarksopen=true, colorlinks, %注释掉此项则交叉引用为彩色边框(将colorlinks和pdfborder同时注释掉) pdfborder=001, %注释掉此项则交叉引用为彩色边框 linkcolor=blue, anchorcolor=blue, citecolor=blue, %pagebackref ]{hyperref} |

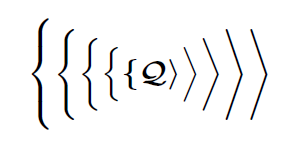

latex-公式例子-加粗-括号

\documentclass{article}

\pagestyle{empty}

\setcounter{page}{6}

\setlength\textwidth{87.0pt}

% Special setting to make delimiters always grow in this example

\setlength\delimitershortfall{-3pt}

\usepackage{bm}

\begin{document}

\begin{equation}

a^2+\mathbf{b^2}=c^2

\end{equation}

$\bm{\Biggl\lbrace\biggl\lbrace\Bigl\lbrace\bigl\lbrace \lbrace

\mathcal{Q}

\rangle \bigr\rangle\Bigr\rangle\biggr\rangle\Biggr\rangle}$

\mathversion{bold}

\begin{equation}

a^2+b^2=c^2

\end{equation}

\end{document}

2010.10.27

这里的简洁与宁静吸引了我

如题,这样的简洁和宁静,决定把博客搬家到这个地方。

刚才用了半天才找到原来博客的地址